Études de cas

Data

- Gestion des processus réglementaires critiques : élimination de la chaîne héritée (1,2 milliard de sensibilités par jour)

- Mise en œuvre de la superposition liée à l’analyse des risques de processus à intégrer dans la plateforme métrique du cadre

- Déploiement réussi de plusieurs métriques dans la nouvelle architecture

- Création de post-traitement dans le cadre de la plateforme métrique pour l’analyse des risques

- Formation sur l’architecture et les composants de la plateforme et les solutions techniques pour tous les acteurs de la plateforme (50-100 personnes)

- Création d’outils de déploiement, processus de Release et CD/CI (Jenkins, Sonar, Git)

- Expertise technique et amélioration des performances sur la chaîne et les processus réglementaires pour répondre aux KPI et aux besoins de production des projets dépendants (30% de gain de temps sur la nouvelle chaîne, 25% de gain de temps sur l’intégration de la chasse d’eau dans le lac)

Environnement :

Java, SpringBoot, Hadoop, Hbase, Hive, Kafka, Spark, Linux, Scrum, SAFE

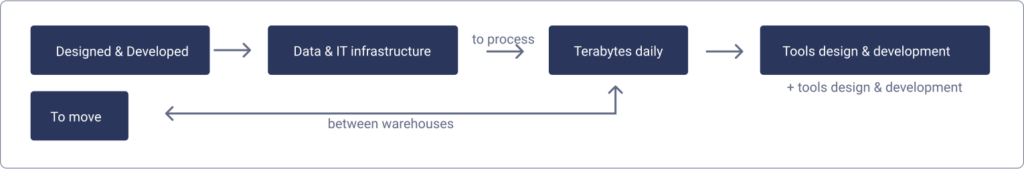

- Migration de l’outil de calcul de risque de marché vers une chaîne dans un cluster Big Data

- Transformation du Framework pour le rendre générique (multi-processus)

- Présentation globale et technique du nouveau Cadre des nouveaux Processus

- Création d’une chaîne de calcul de sensibilités et de limites dans le Lake : jobs Spark pour le Metric Processor et le versioning des métriques, job de chargement des données dans le cube ActivePivot, création d’une Web App entre le Lake, le cube et les outils de visualisation

Environnement :

Java, SpringBoot, Hadoop, Hbase, Hive, Kafka, Spark, Linux, Scrum, SAFE

Études de cas

Data

- Gestion des processus réglementaires critiques : élimination de la chaîne héritée (1,2 milliard de sensibilités par jour)

- Mise en œuvre de la superposition liée à l’analyse des risques de processus à intégrer dans la plateforme métrique du cadre

- Déploiement réussi de plusieurs métriques dans la nouvelle architecture

- Création de post-traitement dans le cadre de la plateforme métrique pour l’analyse des risques

- Formation sur l’architecture et les composants de la plateforme et les solutions techniques pour tous les acteurs de la plateforme (50-100 personnes)

- Création d’outils de déploiement, processus de Release et CD/CI (Jenkins, Sonar, Git)

- Expertise technique et amélioration des performances sur la chaîne et les processus réglementaires pour répondre aux KPI et aux besoins de production des projets dépendants (30% de gain de temps sur la nouvelle chaîne, 25% de gain de temps sur l’intégration de la chasse d’eau dans le lac)

Environnement :

Java, SpringBoot, Hadoop, Hbase, Hive, Kafka, Spark, Linux, Scrum, SAFE

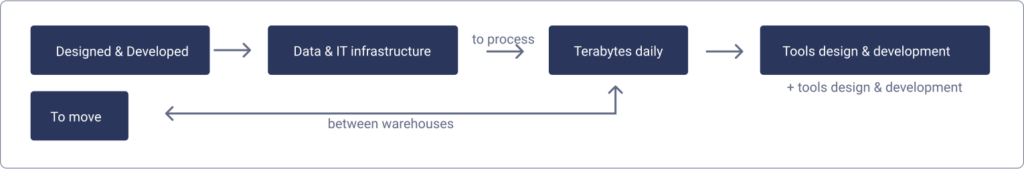

- Migration de l’outil de calcul de risque de marché vers une chaîne dans un cluster Big Data

- Transformation du Framework pour le rendre générique (multi-processus)

- Présentation globale et technique du nouveau Cadre des nouveaux Processus

- Création d’une chaîne de calcul de sensibilités et de limites dans le Lake : jobs Spark pour le Metric Processor et le versioning des métriques, job de chargement des données dans le cube ActivePivot, création d’une Web App entre le Lake, le cube et les outils de visualisation

Environnement :

Java, SpringBoot, Hadoop, Hbase, Hive, Kafka, Spark, Linux, Scrum, SAFE